如何统计站点中下载次数最多的文件? 从 Antezeta 学来一招,在配置文件中添加一段 ExtraSection ,类似如下:

ExtraSectionName10="Downloads (doc,rar,sql,pdf,rtf,sh,tgz,zip) - Top 10" ExtraSectionCodeFilter10="200 304" ExtraSectionCondition10="URL,(.*((\.doc)|(\.rar)|(\.sql)|(\.pdf)|(\.rtf)|(\.sh)|(\.tgz)|(\.zip)))" ExtraSectionFirstColumnTitle10="Download" ExtraSectionFirstColumnValues10="URL,(.*)" ExtraSectionFirstColumnFormat10="%s" ExtraSectionStatTypes10=HBL ExtraSectionAddAverageRow10=0 ExtraSectionAddSumRow10=1 MaxNbOfExtra10=10 MinHitExtra10=1

可以添加或减少需要匹配的文件类型。

有朋友问我 Blog 首页下方的"最多阅读的文章"如何得到的,其实也是用 Awstats 得到的数据。细节内容请参考:AWStats Enhancements and Extensions。

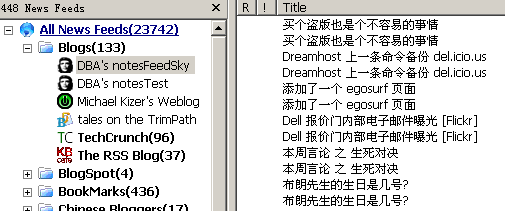

另外,根据 添加 egosurf 页面 的思路,又添加了在线书签的页面。不过遇到一个非常奇怪的原因。非常奇怪...

无独有偶,在后台 web 服务器的错误访问日志上也观察到很奇怪的现象,奇怪,非常非常奇怪 @*%*$$&*.....ooooooops